Einen der wichtigsten Punkte, den man als Content Producer für Virtual Reality Videos beachten muss, ist die Frage, wohin letztendlich der Zuschauer überhaupt schauen wird, wenn er die VR-Brille auf hat. Eine der effektivsten Methoden, um den Blick zu beeinflussen, ist die Nutzung von 360° Sound bei der Vertonung.

Bei Messen und Vorträgen sehe ich immer wieder – und ich zähle mich da mit: es gibt viele Vermutungen, doch ob der VR-Konsoment der Story komplett folgen konnte oder etwas übersehen hat, wird selten überprüft. Was man bräuchte, ist also eine Versuchsreihe, bei der Spatial Audio mit Statischem Sound verglichen wird, und in wie weit sich Versuchsgruppen unterscheiden – am besten mit einer 360° Heatmap.

Eine Forschungsarbeit, die ich nie alleine umsetzen könnte. Doch zum Glück gibt es ja das Münchner „Munich VR 360° Video Meetup“. Dort lernte ich Sylvia Rothe von http://rubin-film.de/ kennen, welche nun ihren Doktor am VR Lab LMU München macht. Kurzfassung: Sie kann Programmierung, ich kann Ton. Beide sind begeistert von VR und wollten genau diese Problemstellung untersuchen.

Update 2019/06

Das Ergebniss dieser Studio wurde nun im offiziellem Rahmen veröffentlicht. Mit den Proceedings der Tonmeistertagung wurde das passende Paper veröffentlich und ist damit wissenschaftlich akzeptiert. Ich freue mich einen kleinen Beitrag dazu leisten konnte, wie Ton in der virtuellen Realität wahrgenommen wird.

Crossing Borders – Eine Fallstudie

Ausgangsmaterial ist eine Episode der 360° Dokumentation Crossing Borders, über ein Waisenhaus in Kambodscha, genannt CPOC. Sie enthält sehr viele unterschiedliche Sequenzen, wie Interviews, Offsprecher, Landschaften, Menschen, Tiere und Motorräder. Die Musik wurde hierfür außen vorgelassen und stumm geschalten. Es wurde also eine eigene kleine App in Unity programmiert, welche die Blickrichtung als Datensätze speichert, womit sie später gesammelt und für die 360° Heatmap weiterverarbeitet werden können. Das Ganze einmal mit dreidimensionalem Sound und Head-Tracking (Ambisonics, tbe-format) und einmal als ganz normales Stereo (binauraler Down-Mix von der 0° Azimut Position, also die „Bild-Mitte“ des equirectangularen Bildes). Hier ein Screenshot aus dem Film, in den Bildern unten folgt die jeweilige 360° Heatmap.

Versuchsumsetzung

Der Versuchsaufbau sah aus wie folgt:

- Proband nimmt auf einem Drehstuhl platz

- geschaut wird der 9-minütige Clip auf der GearVR mit Kopfhörern

- Die Gyroskop-Daten der Kopfbewegung werden als .vtt Dateien gesammelt und auf dem Samsung Galaxy S7 gespeichert

- zusätzlich werden die wichtigsten Erkenntnisse festgehalten

Somit gab es zwei Nutzergruppen, eine die hier als „Spatial“ und eine die als „Static“ bezeichnet wird. Beide sahen das selbe Video, hörten aber einen unterschiedlichen Ton.

- Statisch bedeutet, das sich das Bild zwar gedreht hat, wie man es von VR kennt, der Ton aber immer gleich bleibt, was als Head-Locked bezeichnet wird und einen Downmix darstellt und als statisch binaurales Stereo bezeichnet werden kann. Der Soundtrack war also für jeden Nutzer dieser Gruppe immer der selber und nicht von der Kopfbewegung abhängig.

- Spatial bedeutet, dass der Ton, genau wie das Bild, durch Head-Tracking seine Richtung ändert, wie es in der Realität ist, also interaktiv vom Nutzer verändert wird. Synonyme wäre 3D Audio, immersiver Sound, dynamischer binaurales Stereo etc. Der Soundtrack wurde für jeden Nutzer als etwas anders wahrgenommen. Während das so genannte 360° Schallfald für jeden Nutzer das Selbe war, wurde durch die Kopfbewegung die Richtung, abhängig vom Bild in Echtzeit gerendert, VR-Sound eben.

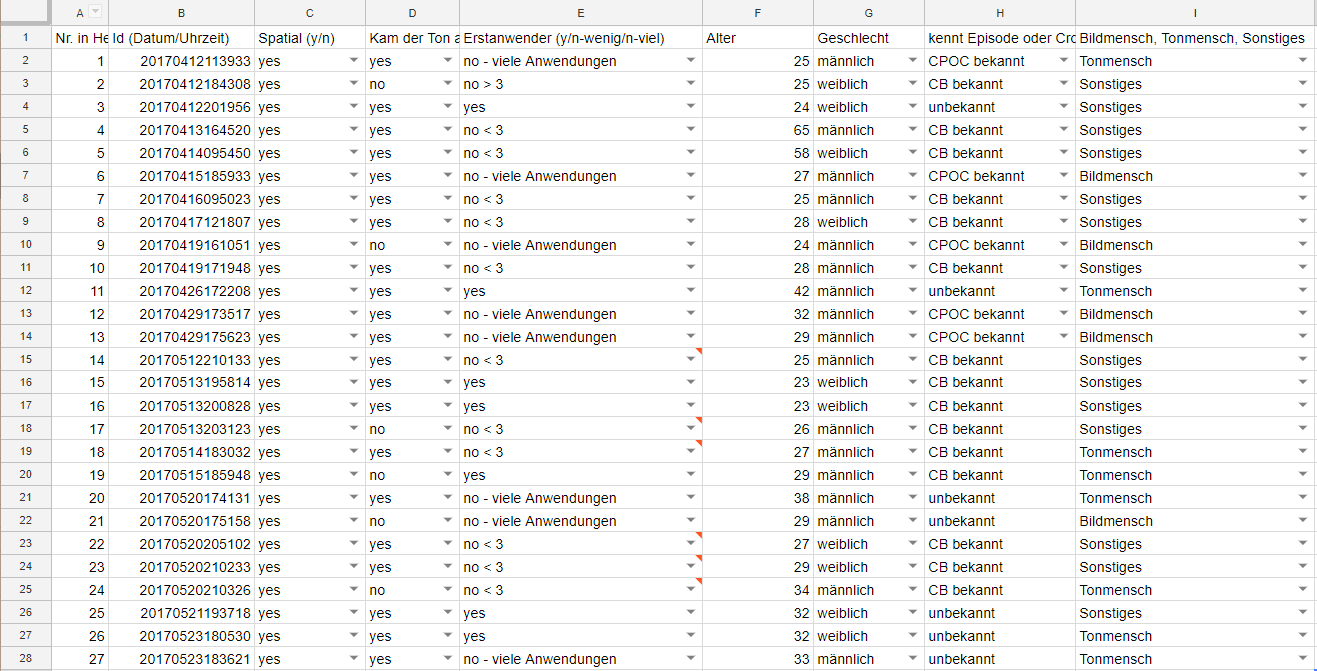

Mittlerweile konnten wir pro Versuchsgruppe etwa 20 Auswertungen machen, also ingesamt 50. Wir spezifizierten Alter, Gechlecht, Beruf und wie erfahren der Proband mit dem Medium Virtual Reality ist.

So sah der entsprechende Fragebogen aus:

Ergebnisse

Gemeinsamkeiten

Dann wollen wir direkt mit den Gemeinsamkeiten loslegen:

- Menschen ziehen Blicke an sich, Nicht-Menschen tun das nicht. Das ist leicht vergleichbar mit dem echten Leben. Wir setzen uns ja kaum in einen Raum und starren die Wand an, wenn im gleichen Raum ein Mitmensch ist. Manche Gebäude wurde fast gar nicht angesehen, was im Umkehrschluss aber bedeutet, dass manche Objekte den Blick von sich weg und damit zu einem gewünschten Objekt leiten können. Damit können sie ähnlich einer Bühne beim Theater genutzt werden, um ein 360° Panorama aufzubauen.

- die meisten Nutzer haben geradeaus geschaut, lediglich mit 15° Elevation nach oben/unten, sowie mit 30° Azimuth nach links/rechts. Die Winkel zeigen, wie weit wir unseren Kopf ungehindert bewegen können, ohne unangenehme Verbiegungen machen zu müssen, oder den Rumpf mitzudrehen. Das lag auch am Content, dessen meiste Aktionen in der Front gespielt haben. Darüber hinaus sind wir aus unserem täglichen Leben gewohnt, dass das wichtigste in der Horizontalen passiert und selten etwa über oder unter uns.

- wenn man eine Szene zum zweiten Mal zeigt, in diesem Fall einen Interview-Partner, dann fängt der Nutzer sehr schnell an, seinen Blick schweifen zu lassen, weil er die Szene eben wieder erkennt und sich schneller zurecht findet.

- Manche Sounds machten keinen Unterschied, ob sie immersive 3D waren oder nicht, z.B. Straßenverkehr. Ich sage gerne „mache den Sound glaubwürdig, nicht realistisch“. Wenn ein Nutzer Straßenverkehr hört und Autos sieht, ist es ihm meist egal, ob der Sound jetzt dreidimensional ist oder nicht, solange er nicht aus der falschen Richtung kommt. Bei Elemente die Menschen spielt das aber sehr wohl eine Rolle.

Unterschiede

Jetzt wird es (noch) interessanter, mit einigen ersten, vorsichtigen Schlussfolgerungen:

- die Nutzer der Gruppe mit statischem Sound, haben sich vom Interviewpartner nach meist 8 Sekunden weggedreht. Mit Spatial Sound sind die Leute eine bis drei Sekunden länger geblieben, also fast immer, bis die Scene endete und die Nächste begann. Meine Vermutung ist, dass Menschen mit 3D Audio ein besseres Gefühl für die Präsenz von Menschen im virtuellen Raum haben. Im echten Leben würde man ja auch nicht einfach seinen Kopf wegdrehen, wenn eine Person gerade vor einem spricht. Wenn doch, hört man, wie die Stimme auf dem linken oder rechten Ohr immer noch gut zu hören ist, woran man daran erinnert wird, dass die Person zwar nicht mehr zu sehen, aber immer noch da ist und man selber sich gerade etwas unhöflich weggedreht hat. Mit statischem Stereo-Sound geht dieser Effekt wohl verloren, weil die Nutzer sich schneller weggedreht haben.

- ähnlich anwendbar ist es mit Details wie Tieren und sich bewegende Objekte (wie Motorräder etc.). Es gab eine Szene mit einem Schwein, bei dem die Gruppe mit 360° Sound sich zu diesem hingedreht und gar nicht mehr weggesehen haben, während die Gruppe mit statischem Ton das Schwein zwar gesehen hat, aber dann weiter die Gegend erkundet hat.

- Was die 360º Heatmap und der Fragebogen zeigen konnten: Die Gruppe mit Spatial Sound hat den Interviewpartner wesentlich schneller gefunden und war auch weniger vom Voice-Over irritiert. Sie konnten sehr leicht unterscheiden, ob eine Sprachaufnahme in der Szene zu einem Menschen gehört (spatialer Sound), oder als Erzähler-Stimme Voice-Over (Mono, im-Kopf Lokalisation) gedacht ist. Während die Gruppe mit statischem Sound beide Sprachelemente nur als Mono wahrnehmen kann und damit schneller zu Verwirrung führen kann.

- nachdem den Teilnehmern nicht gesagt wurde, „warum diese Studie“ gemacht wird, konnten sogar einige Tonmenschen sich im Nachhinein nicht daran erinnern, ob der Ton sich mitgedreht hat oder nicht. Es scheint also ein schmaler Grat zwischen einem natürlichen, immersiven Erlebnis sein oder einem Höreindruck sein, der ohne Headtracking die Immersion kaputt macht.

Gelernte Lektionen

- Manche HMD (head-mounted displays) sind überhitzt, da sie mit der Wiedergabe von einem 360° Video mit 360° Ton und dem sammeln der Gyroskop-Daten beschäftigt waren.

- Die Samsung GearVR bestitz kein Eyetracking, kann also nur die Blickrichtung, nicht aber die tatsächliche Augenbewegen nachvollziehen. Ich vermute, dass die Unterschiede hier v.a. am Anfang der Szene zu sehen sein werden, wenn viele kurze, unbewusste Blicke passieren, bevor sich der Kopf zur gewünschten Bildmitte dreht.

- Ein Großteil der Handlung des Materials (Crossing Borders), passierte bei 0° Azimuth, womit wir auch dort die meisten Daten sammelten. Wenn der Content den Nutzer mehr dazu zwingen würde, woanders hinzusehen und extremer mit Sound-Triggern arbeitet, wäre das Ergebnis wohl noch deutlich offensichtlicher.

- Außerdem war das statische Stereo hier ein binauraler Downmix, der mit dem Spatial Sound identisch klang, wenn man frontal auf 0° gesehen hat. Lediglich das Head-Tracking war anders, lieferte aber sonst schon ein ähnliches immersives Klangbild.

- zusätzliche Einflüsse, die schwer zu ergründen sind und weiter untersucht werden müssen: Der Content, bzw. das Audiovisuelle an sich, HRTF (head-related transfer function), die Erfahrung des Nutzers mit VR und psychoakustische Effekte

Fazit

Dies war mein erster Versuch, um herauszufinden, ob meine Arbeit als VR-Sound Designer überhaupt einen Unterschied macht und zum Glück tut es so. Es gibt aber noch viel Arbeit zu tun um die Auswirkung von Virtual Reality Sound auf Menschen belegen, ich hoffe aber, dass es hilfreich ist und weiter untersucht wird! Immersives Audio is nichtsdestotrotz großartig und gerade erst dabei, im Bewusstsein der Öffentlichkeit anzukommen, was ich durch Vorträge, Workshops und Mentering weiter versuche voranzutreiben.

YouTube-Analytics VR 360° Heatmap

Weil ich oft gefragt wurde, wieso ich nicht die YouTube Heatmap-Bericht für 360°-Videos nutze, hier ein paar Sätze. Es ist kein Geheimnis, dass beim YouTube-Kanal des Nutzers Unmengen an Daten gesammelt werden: Wann, wo, wer, wie lange das Video geschaut.

Nun kommt für VR/360 der neue Clue hinzu: Wohin haben die YouTube-Viewer geschaut? Vom Prinzip genau das, was oben beschrieben wurde, doch es gibt einige Fakten, die mit Vorsicht zu genießen sind:

Pro:

- Man muss keine eigene App programmieren und kann sich ganz bequem Daten sammeln lassen

- Die Auswertung läuft wie von alleine und kann bei weitem mehr Nutzer-Aktivitäten auswerten, als man das alleine könnte

Contra:

- Die 360° Heatmap in VR-Videos wird erst ab einer bestimmten Anzahl von Views für den Nutzer freigeschaltet, bei ca. Eintausend

- es gibt keinen Versuchsaufbau, womit jeder Nutzer in einer ganz anderen Nutzungs-Umgebung oder unterschiedliche Geräte nutzt. Ob hier mit einer Cardboard auf der YouTube App geschaut wurde, das Smartphone einfach nur auf dem Tisch lag und gar nicht bewegt wurde…schwer zu sagen.

Trotzdem ist es ein tolles Feature und schön von YouTube, dass es implementiert wurde, um Virtual Reality Produzenten zu helfen.

Quelle:

https://www.vrtonung.de/360-heatmap-spatial-vs-static-sound/